Les spécialistes de l’intelligence artificielle – qui ont connu le dernier creux de la vague entre la fin des années 1980 et le début des années 1990 – ne cessent de répéter que l’informatique quantique, voire les technologies quantiques à une plus grande échelle, sont vouées au même sort. Elles pourraient pâtir d’une réduction drastique des dépenses de recherche publique et du financement de l’innovation. Si les spécialistes font cette hypothèse, c’est qu’ils constatent que les marchands de technologies quantiques, et même des chercheurs, créent une bulle technologique. Comment ? Avec des promesses – survendues et non-tenues – dans le domaine de l’informatique quantique, et en se plaignant de l’apparente lenteur des progrès dans le domaine.

Une « course au quantique » a été lancée par de nombreux gouvernements, en particulier les Etats-Unis, la Chine et d’autres pays développés, en raison des préoccupations liées à la « souveraineté technologique ». Elle alimente artificiellement l’engouement pour le quantique. Enfin, les récentes campagnes de financement massives lancées par des start-ups comme IonQ, PsiQuantum et Rigetti ont aussi participé à cette idée qu’une bulle quantique s’était formée. Certains vont jusqu’à dire – allant bien trop loin – que l’informatique quantique est une escroquerie créée par des scientifiques, afin d’obtenir des fonds pour des projets de recherche hasardeux.

En s’efforçant d’adopter un point de vue nuancé, cette note explique en quoi consiste la bulle quantique, en la distinguant des autres bulles de l’ère numérique (intelligence artificielle symbolique, télévision 3D, impression 3D grand public, réalité virtuelle et augmentée, blockchain et crypto-monnaies) et de celles liées à la science. Il s’agit de proposer quelques idées et un code de conduite pour l’écosystème quantique, qui permettrait d’éviter les pièges de la bulle quantique, tout en conservant les avantages d’un écosystème scientifique et technologique dynamique. La note s’appuie aussi sur des travaux antérieurs de philosophes des sciences dans le domaine de l’éthique quantique et de l’innovation responsable, et tâche de les compléter1.

La recherche fondamentale quantique est active depuis 1900, date de la découverte fondamentale des quanta d’énergie par Planck. Depuis, la seule période creuse dans le domaine a été la Seconde Guerre mondiale, quand des scientifiques américains et allemands comme Enrico Fermi, John Von Neuman et Werner Heisenberg ont été mobilisés pour travailler sur l’arme nucléaire2. Cela a permis la création des premières bombes atomiques et leur utilisation malheureuse au Japon. C’est l’un des nombreux cas où l’innovation n’a pas été synonyme de progrès, créant une rupture philosophique entre la science et la société. Cette « crise de la science » résonne encore aujourd’hui chez les scientifiques comme l’archétype du cas de conscience auquel les scientifiques peuvent être confrontés.

D’importantes retombées industrielles de la recherche en physique quantique sont apparues avec l’invention du transistor en 1947, du laser au début des années 1960 et de nombreuses autres prouesses technologiques (téléviseurs, diodes électroluminescentes, GPS, …) qui ont conduit à l’ère numérique, fondée sur la « première révolution quantique », dont nous bénéficions aujourd’hui.

Dans la « seconde révolution quantique », les scientifiques s’intéressent au contrôle d’objets quantiques individuels (atomes, électrons, photons) et ont recours aux phénomènes de la superposition et de l’intrication quantiques. Le début des années 1980 a été déterminant. Yuri Manin et Richard Feynman ont fait part de leur volonté de créer respectivement des ordinateurs quantiques (1980) et des simulateurs quantiques (1981), puis Alain Aspect et son équipe ont réalisé (1982) leur célèbre expérience de violation des inégalités de Bell en utilisant des photons intriqués à distance3.

Depuis, plus de 40 ans se sont écoulés. Même si les progrès de la science quantique ont été continus, les ordinateurs quantiques pratiquement utilisables, offrant un avantage significatif par rapport aux ordinateurs classiques, n’existent pas encore. Cette évolution se fait attendre4. Cependant, trois autres innovations concrètes de cette seconde révolution quantique sont bel et bien présentes : les télécommunications quantiques, la cryptographie et la détection. Dans une certaine mesure, cette dernière mise en pratique des découvertes quantiques est insuffisamment médiatisée.

1. En quoi consiste une « bulle »

Le terme de « bulle » renvoie à la surmédiatisation et aux affirmations exagérées, excessives ou trompeuses qui s’appliquent à des produits particuliers, des catégories de produits, des tendances technologiques, des domaines scientifiques, des personnalités telles que des artistes ou des hommes politiques, ou à de la spéculation financière ou des escroqueries5. Une « bulle » peut reposer sur des phénomènes sociétaux généraux autant que sur des stratégies de marketing explicites, bien pensées et planifiées. Une bulle est parfois confondue avec les exagérations marketing qui peuvent servir à la mettre en place. Elle n’est pas non plus « le buzz », moyen discret de diffuser un contenu promotionnel, avant qu’il ne constitue une bulle.

Les bulles existaient bien avant internet, mais elles peuvent désormais prendre bien plus d’ampleur du fait de l’utilisation des médias6. En tant que stratégie marketing, le fait de créer une bulle peut avoir un intérêt dans divers domaines : par exemple dans la mode, pour promouvoir une marque ou un style. Elle peut même être fondée sur une pénurie artificiellement créée, ou sur une fausse forte demande. Par ailleurs, de nombreuses anciennes combines financières de type système de Ponzi ont été créées à l’aide de mécanismes de bulles médiatiques.

Bulles scientifiques et technologiques

Les bulles scientifiques et technologiques n’impliquent pas les mêmes acteurs que dans le cas des bulles relatives à la mode, la finance ou la politique. Elles dépendent en grande partie de la manière dont la communauté scientifique, l’industrie et la société interagissent, de manière contingente. Lorsque le monde commercial entre en jeu, les valeurs et les systèmes commerciaux et financiers deviennent alors de puissantes chambres d’écho.

Les bulles technologiques ne sont pas mauvaises en elles-mêmes7. Tout dépend en fait de leur ampleur, et de si elles tiennent ou non leurs promesses. Les effets d’annonce et la médiatisation peuvent être des atouts : ils stimulent la recherche et l’innovation à l’échelle mondiale8. Leur principal intérêt est d’attirer les financements des gouvernements et du secteur privé. Indirectement, une bulle peut contribuer à faire progresser la science et à rendre un domaine attractif pour de nouveaux talents. Et contrairement à la célèbre tirade de Gene Kranz, l’échec est une option. L’absence totale d’échec signifierait qu’un nombre insuffisant de pistes ont été abordées. C’est particulièrement vrai dans le domaine des technologies quantiques : au-delà des investigations sur les nombreux types de qubits d’ordinateurs quantiques, une grande diversité d’options technologiques sont explorées.

Une bulle scientifique peut aussi se produire bien avant que n’interviennent les sphères entrepreneuriales et commerciales. C’est le cas quand divers aspects positifs ou rémunérateurs de la science sont exagérés de manière inappropriée – cette évaluation reposant bien entendu sur un jugement de valeur9. La bulle peut apparaître en premier lieu avec certains titres d’articles scientifiques créés par des communicants de laboratoires de recherche10. C’est souvent le cas dans les sciences de la vie, où il avait été questions de cellules souches pluripotentes et d’anticorps monoclonaux11 permettant de guérir divers cancers. Ce type de communication peut s’expliquer par la manière dont les chercheurs sont financés et récompensés dans la plupart des pays. Les fournisseurs de technologie sont loin d’être les seuls à se faire concurrence pour être financés. De même, la science est un domaine très compétitif, où l’on recherche la visibilité, la reconnaissance, les carrières réussies, et les financements publics et privés.

La bulle est susceptible d’être amplifiée quand la communication scientifique et les publications universitaires sont transcrites en des termes compréhensibles par tous, dans les médias traditionnels12. L’existence de serveurs comme arXiv peut aussi contribuer à cette dynamique : sur cette plateforme sont publiés des articles qui n’ont pas encore été validés par la communauté scientifique, et dont les médias s’emparent parfois. Mais il faut garder à l’esprit que la plupart des articles scientifiques qui bénéficient d’une visibilité médiatique ont été évalués et validés par d’autres chercheurs.

Émotions et irrationalité

L’engouement pour les projets scientifiques et technologiques fait entrer en collision, d’une part des émotions et de l’irrationnel et, d’autre part, une rationalité scientifique, technologique, voire commerciale. Les bulles procèdent d’une forte confiance dans le progrès induit par la science, mais aussi d’une confusion entre les expériences de laboratoires et ce qui relève des solutions applicables au niveau de la production. La bulle scientifique et technologique n’est pas réductible au schéma classique des autres bulles, fondées sur la conjonction d’attentes rationnelles et d’un contrat sociétal sur les investissements requis pour produire de la valeur13.

Sur le plan émotionnel, une bulle suscite l’espoir, l’envie, et la crainte. L’espoir, tout d’abord, de résoudre des problèmes décisifs, relatifs à la santé ou au changement climatique. L’envie ou la jalousie ensuite : les investisseurs et les entrepreneurs ne veulent pas manquer une occasion de s’enrichir, et les gouvernements sont soucieux de ne pas être déclassés par d’autres pays. La crainte enfin : les entreprises redoutent de perdre leur compétitivité ou de manquer des opportunités commerciales.

Les émotions liées à l’hypermédiatisation sont aussi plus facilement manipulables. Car le public cible ignore souvent les différents obstacles scientifiques ou technologiques à la création de solutions réelles. L’engouement pour une technologie peut sans problème s’appuyer sur la pensée magique et faire référence, occasionnellement, à la science-fiction14.

« Le cycle de la hype » de Gartner

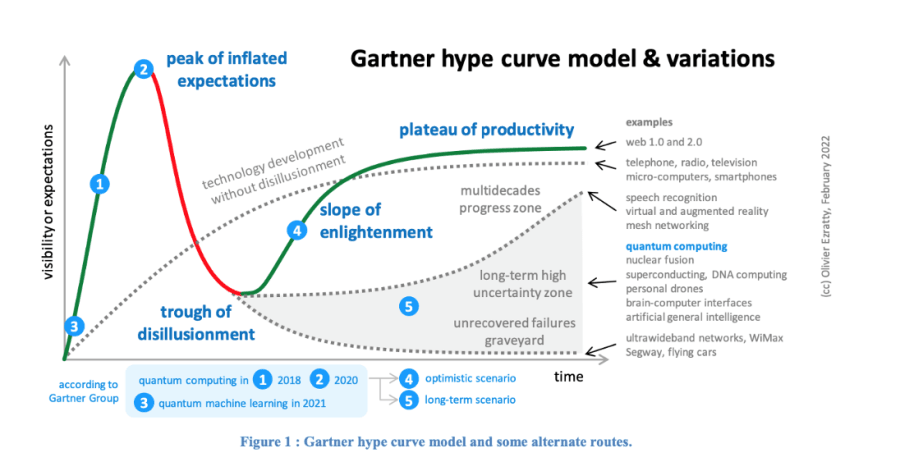

La formation des bulles technologiques a été étudiée par le Gartner Group, avec leur célèbre modèle de « cycle de la hype » créé en 199515. Ce modèle tente d’appréhender l’évolution de la visibilité et du succès des technologies de manière prédictive. Le modèle utilise une courbe non linéaire avec le temps non gradué en X et la visibilité ou les attentes en Y. Après l’apparition d’une nouvelle technologie, le premier pic de visibilité correspond à un « pic d’attentes exagérées ». Ceci se produit lorsqu’un buzz très important est amplifié par les médias, qui s’intéressent à la technologie en des termes quasi-assimilables à de la pensée magique. Ce buzz peut être créé et alimenté, selon la technologie, par des scientifiques, des analystes, des consultants, des influenceurs, des entrepreneurs, des entreprises et, parfois, les gouvernements eux-mêmes. Avec l’informatique quantique, nous nous trouvons aujourd’hui sur ce pic de visibilité, comme le montre la courbe (1).

Mais lorsque les attentes importantes suscitées ne correspondent pas aux capacités ni aux avantages réels de la technologie, on tombe alors dans un « creux de désillusion ». La confiance dans l’innovation en question et ses créateurs disparaît, et les médias s’en désintéressent. Cet écart entre des attentes démesurées et les retombées concrètes de la science et de la technologie peut conduire à un retrait d’engagements financiers, comme cela s’est produit avec l’intelligence artificielle au cours de ses deux passages à vide, au début des années 1970 et dans les années 1990. Cela peut également se produire lorsqu’une innovation technologique n’induit pas de progrès sociétal et n’a pas d’utilité clairement perceptible ou identifiable.

Dernier moment : lorsqu’une technologie arrive à maturité, elle récupère en visibilité, avec une « pente vertueuse » croissante qui débouche sur un « plateau de productivité ». La technologie peut alors se généraliser et se banaliser sur le marché, que ce soit dans le domaine de l’entreprise ou du grand public, selon la technologie.

La courbe de Gartner est un modèle empirique trop simpliste, qui ne rend pas bien compte de ce qui peut se produire dans le cas des sciences et des technologies révolutionnaires16. Elle est construite en ajoutant une courbe de Bell de « buzz » initial et une courbe S de maturité technologique, qui ne reposent pas sur la même métrique. Pour qu’elle soit pertinente, il faudrait ajouter les raisonnements scientifiques, technologiques et même commerciaux, qui sont déterminants pour étudier les bulles. La courbe suit surtout la réaction émotionnelle aux nouvelles sciences et technologies, et elle est dépourvue de toute rationalité. Elle présuppose par ailleurs que la visibilité, les attentes et les besoins, en ce qui concerne une technologie, sont corrélés. Autre prémisse problématique : la courbe part du principe qu’à un moment donné, le domaine technologique en question sera couronné de succès. Mais que se passe-t-il si la science et la technologie n’y parviennent pas ? Que se passe-t-il si les nouveaux besoins auxquels l’innovation est censée répondre n’existent pas vraiment ? Postuler la perpétuation des diverses technologies, c’est oublier celles qui ont totalement échoué pour une raison ou une autre17.

Le marché déborde d’un nombre croissant de technologies à la mode. Comment cela affecte-t-il leur visibilité ? Parfois, une technologie en vogue n’est pas bien définie, comme les « nanotechnologies », ce qui fait que le marché s’affole18. « Le creux de la désillusion » peut alors être très long et s’étendre sur plusieurs décennies. Nous y sommes encore pour l’IA symbolique et c’est peut-être ce qui arrivera à l’informatique quantique19.

L’une des principales lacunes de la courbe est que le Gartner Group l’utilise pour conseiller les entreprises sur le moment où adopter de nouvelles technologies. On pourrait adopter une autre logique et éviter le suivisme aveugle20. Les gagnants de l’innovation sont souvent à contre-courant !

La seule raison valable de suivre la tendance, c’est que l’adoption d’une technologie nécessite parfois un solide écosystème d’applications et de services. Mais celui-ci pourrait être évalué sans avoir recours à des études empiriques sur le battage médiatique.

Les nouvelles technologies ou domaines scientifiques peuvent donc traverser d’autres cycles, comme le montre la courbe (1). Certaines technologies réussissent par exemple sans s’appuyer sur une bulle médiatique. C’est le cas des micro-ordinateurs, qui n’ont pas connu de temps faible entre leurs débuts au milieu des années 1970 et leur adoption par le grand public à la fin des années 1990. Il existe par ailleurs une zone grise intéressante dans laquelle deux situations opposées peuvent se produire, après le « creux de désillusion ». Ou bien, par une bulle publicitaire qui fonctionne sur le long terme, la technologie peut progresser considérablement ; ou bien elle rejoint le triste cimetière des innovations qui n’ont pu être sauvées. L’informatique quantique pourrait entrer et rester dans cette zone grise pendant les deux prochaines décennies, à moins que des découvertes scientifiques et technologiques capitales ne se produisent dans les dix prochaines années.

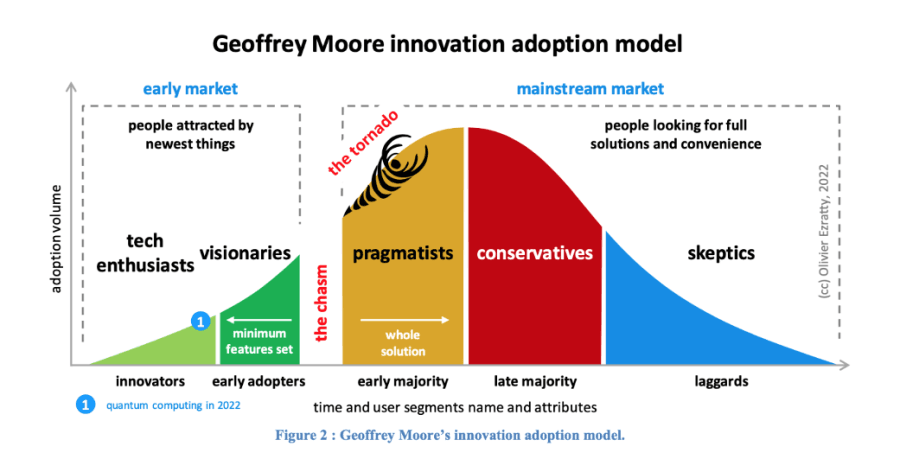

D’autres modèles pour étudier ces cycles d’innovations peuvent être envisagés, mais ils s’intéressent moins aux effets de bulle et ne tiennent pas vraiment compte de l’incertitude du devenir des innovations technologiques profondes. Le modèle d’innovation de Geoffrey Moore, avec son « gouffre » et sa « tornade », décrit la manière dont les innovations deviennent courantes grâce à leur adoption par des groupes d’utilisateurs successifs, indépendamment de leur connaissance de la technologie, comme le montre le graphe (2)21. Il décrit avec précision le gouffre qui sépare les premiers adeptes de la technologie et la majorité précoce qui les suit (ou non) et permet que l’offre se généralise par la suite. Cela correspond à l’obstacle à franchir pour qu’une technologie se diffuse. Lorsqu’elle y parvient, le marché se développe rapidement grâce à l’expansion des écosystèmes et à la fluidification de la distribution, avec parfois une baisse significative des prix. Cette période est un moment de « tornade » au cours duquel les positions dominantes sont consolidées, jusqu’à créer des monopoles lorsque les solutions reposent sur de grands écosystèmes.

Si nous devions utiliser le modèle de Moore pour étudier l’informatique quantique, nous dirions que nous en sommes au stade de l’innovation ; les systèmes de traitement quantique pré-NISQ existants étant encore des dispositifs expérimentaux22. Pour que le gouffre soit franchi, le prérequis minimum est d’obtenir un avantage quantique pour résoudre des problèmes commerciaux pratiques. Ce gain peut être lié à la vitesse de calcul, à la qualité des résultats, à l’empreinte énergétique de la solution voire tout simplement à son coût économique. Les premiers utilisateurs prendront le train en marche, sous un délai indéterminé, quand les ordinateurs quantiques opérationnels à grande échelle seront opérationnels. Puis, lorsque l’écosystème des logiciels et du cloud se développera, le gouffre sera passé et nous verrons la majorité utilisateurs adopter massivement l’informatique quantique.

Le modèle de Clayton Christensen permet de rendre compte de certaines avancées. À savoir celles de faible technicité, qui deviennent ensuite courantes, tout en provenant de modèles d’entreprise innovants23. Cette grille de lecture fonctionne lorsqu’une nouvelle technologie et ses applications élargissent considérablement un marché donné. Les exemples classiques sont l’ordinateur personnel et le smartphone. Il est moins applicable à l’informatique quantique étant donné qu’il s’agira, au moins au début, d’un sous-marché du domaine précis de l’informatique à haute performance.

Dans les deux cas, les modèles de Clayton Christensen et de Geoffrey Moore décrivent les détails de la mise en place de la « pente vertueuse » dont il est question dans le cycle de Gartner, qui correspond au moment où la technologie commence à fonctionner réellement. Dans le cas de l’informatique quantique, ces modèles deviendront pertinents lorsque les ordinateurs quantiques se développeront et offriront un avantage avéré par rapport aux ordinateurs classiques. Mais certains écosystèmes d’outils logiciels et de plateformes telles que IBM Qiskit commencent déjà à se développer et peuvent être étudiés suivant le modèle de Geoffrey Moore. Ils préparent le marché à la diffusion de solutions logicielles et de nouvelles fonctionnalités, qui deviendront effectives quand les ordinateurs quantiques seront opérationnels à grande échelle.

2. Enseignements de l’histoire et analogies

Les dernières décennies ont été marquées par une explosion de technologies numériques et autres, dont la plupart ont été déployées avec succès à grande échelle. Les micro-ordinateurs ont envahi le monde des passionnés d’informatique, puis l’espace de travail et, enfin, nos foyers. Malgré les craintes exagérées liées au bogue du millénaire, le passage à l’an 2000 a marqué le début de l’ère numérique pour les consommateurs, avec la musique accessible sur le web, la photographie numérique, la vidéo et la télévision numériques, le commerce électronique, l’internet mobile, l’économie de partage, toutes sortes de services de désintermédiation et, enfin, l’informatique en nuage (cloud computing).

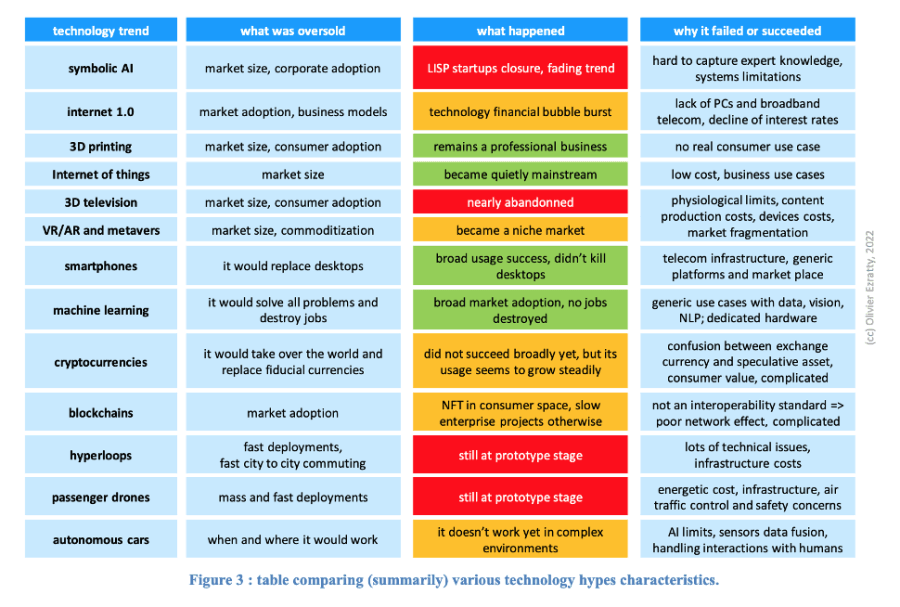

Il y a toutefois eu quelques échecs, avec différentes bulles médiatiques et des résultats contradictoires. Dans de nombreux cas, alors que ces bulles atteignaient leur paroxysme, le bon sens appelait à faire preuve d’un certain scepticisme. Dans le tableau suivant (3), je propose une comparaison approximative des succès et des échecs des technologies très médiatisées, ainsi qu’une explication simple de ces résultats.

Je me penche ici sur certaines catégories de produits et non sur des produits particuliers qui ont réussi et se sont effondrés ou bien se sont effondrés immédiatement (Betamax, Altavista, MySpace, Blackberry, Segway, Theranos). Il existe également de nombreuses études de cas que je n’examine pas, comme la propulsion à base d’hydrogène, les véhicules électriques et la médecine de précision.

L’intelligence artificielle symbolique

Dans les années 1980, l’IA symbolique et les systèmes experts étaient à la mode, mais leur mise en œuvre posait des problèmes pratiques. La saisie des connaissances spécialisées était difficile et ne pouvait pas être automatisée lorsque les contenus n’étaient pas massivement numérisés comme ils le sont aujourd’hui. Il existait même des machines spécialement conçues pour faire fonctionner le langage de programmation LISP utilisé pour l’intelligence artificielle.

Elles ne pouvaient pas rivaliser avec les machines classiques basées sur des unités centrales de traitement d’Intel ou d’autres sociétés similaires, qui bénéficiaient sur le long terme de la loi de Moore (Gordon). En conséquence, les deux startups concernées ont échoué avant même d’avoir pu commencer à vendre leur matériel. Ensuite, les systèmes experts sont passés de mode.

L’IA a connu un renouveau avec l’apprentissage profond (deep learning), une extension de l’apprentissage automatique (machine learning) créée par Geoff Hinton en 2006. Le retour de l’IA sur le devant de la scène remonte à 2012, lorsque le deep learning a pu bénéficier d’algorithmes améliorés et de puissants GPU de Nvidia. L’ère actuelle de l’IA est principalement connexionniste, fondée sur des modèles probabilistes d’apprentissage automatique et profond, par opposition à l’IA symbolique fondée sur des moteurs de règles.

Suivant une trajectoire parallèle à celle de l’IA symbolique, les voitures autonomes progressent elles aussi assez lentement. Les défis scientifiques et technologiques sont considérables, en particulier lorsqu’il s’agit de l’interaction entre les voitures autonomes et les humains, qu’ils soient à pied ou dans d’autres véhicules à deux, trois, quatre roues ou plus.

Aujourd’hui, l’intelligence artificielle est un champ qui conduit à s’intéresser à l’éthique, l’innovation responsable et aux questions environnementales – réflexions qui sont souvent menées après coup. L’enseignement que l’on peut en tirer est que, plus tôt ces questions sont étudiées et traitées, mieux c’est.

L’impression 3D grand public

Au début des années 2010, certains analystes ont prédit que l’impression 3D à domicile allait prospérer. Il n’en a rien été. Les utilisateurs n’ont pas jugé nécessaire d’investir 300 dollars ou plus et de longues heures d’impressions pour des pièces de plastique mono-matériau qu’ils pouvaient potentiellement se procurer sur Amazon ou ailleurs pour bien moins cher et, en pratique, plus rapidement. L’échec du marché grand public est donc dû au manque d’intérêt de l’innovation sur le plan pratique et, dans une certaine mesure, à l’inexistence de systèmes d’impression 3D multi-matériaux (plastique, acier, électronique, verre).

Le marché de l’impression 3D continue de croître régulièrement, mais principalement sur les marchés professionnels et dans l’industrie de la fabrication (automobile, aérospatial, …). Nous sommes loin de la « société du coût marginal zéro » imaginée par Jeremy Rifkin en 2015. L’impression 3D n’est pas encore entrée dans les mœurs. Ceux qui prévoient une adoption de l’informatique quantique par les consommateurs doivent en tirer des leçons.

Télévision en 3D et réalité virtuelle / augmentée

Certains échecs relativement récents dans le domaine de l’électronique grand public peuvent être attribués à des problèmes physiologiques. La télévision 3D ne reproduisait pas une véritable expérience de vision stéréoscopique. Il en va de même pour les casques de réalité virtuelle et augmentée actuels.

Google a tenté l’expérience avec ses Google Glass en 2013. Elles étaient moins encombrantes, mais au prix d’une résolution très faible de 640×360 pixels et d’un angle de vue réduit de 13° seulement. Comme produit de consommation grand public, les Google Glass n’ont été vendues qu’entre 2013 et 2015 (voir le bas de la photo 4).

À l’époque, j’ai découvert que la réalité virtuelle et la réalité augmentée étaient limitées, non pas vraiment par la puissance de calcul disponible, mais plutôt par la loi de l’optique classique. Trouver un moyen d’envoyer une image grand angle à haute résolution dans vos yeux est un défi optique très compliqué. Personne n’a trouvé de solution, pas même Magic Leap ou Microsoft avec son HoloLens 2, à voir en haut de la photo (4) ! Pourtant, Magic Leap a levé un total de 2,6 milliards de dollars, soit plus de la moitié de toutes les start-ups quantiques. Elle s’est récemment repositionnée sur le marché de la santé, laissant de côté le marché de la consommation grand public. Maintenant qu’Apple s’est lancé sur ce marché, la donne pourrait éventuellement changer. Mais avec un produit lancé à $3500 qui ne change pas véritablement la donne du côté de l’encombrement, ce n’est pas évident.

Dès lors, il est évident qu’il n’y a pas à s’inquiéter quand certains recommandent de créer des postes de Chief Metaverse Officers au sein des entreprises pour gérer leur présence dans les mondes virtuels24. Lors de la frénésie liée à l’univers virtuel « Second Life » (Linden Labs), qui a atteint son apogée en 2013, certains départements des ressources humaines d’entreprises ont créé des espaces virtuels pour embaucher de jeunes professionnels, comme s’ils présélectionnaient des avatars ! Il n’est pas difficile non plus de deviner pourquoi la 3D et la réalité virtuelle se heurtent à des obstacles liés aux coûts de production. La récente transformation de ces mondes virtuels en métavers ne changera pas grand-chose à la situation.

Blockchain et cryptomonnaies

Nous ne savons pas encore si elles seront un succès ou non. Quelle que soit l’issue, elle ne s’expliquera probablement pas par des raisons scientifiques sophistiquées. Un échec de ces innovations pourrait être dû au manque d’économies d’échelle, à des problèmes d’interopérabilité, des initiatives réglementaires (comme l’interdiction récente des crypto-monnaies et de leur exploitation25 en Chine), à un manque d’acceptation sociétal ou, tout simplement, de valeur réelle pour le consommateur lambda.

La blockchain n’est pas une norme d’interopérabilité en elle-même, puisqu’il y a autant de blockchains que de cas d’utilisation. Elle empêche la création d’un écosystème de plateforme global, comme le web ou même les magasins d’applications pour smartphones, que Google et Apple consolident. L’engouement pour les crypto-monnaies et les startups de la blockchain est actuellement beaucoup plus important que l’engouement pour le quantique.

Au cours du seul deuxième trimestre 2021, les startups de la blockchain ont levé 4 milliards de dollars, soit l’équivalent de toutes les startups quantiques depuis le début de leur existence, et 17 milliards de dollars au cours des six premiers mois de l’année 202126. Ces chiffres s’expliquent par la grande attractivités des startups du secteur financier pour les investisseurs. A l’inverse des startups des technologies avancées, elles ont la capacité de créer des flux de revenus plus rapides.

En tant que sous-catégorie du marché de la blockchain, le Non-Fungible Token (NFT) a fait en lui-même l’objet d’un engouement important avec des niveaux de financement exceptionnels atteints par Sorare (739 millions de dollars, France) et Dapper Labs (607 millions de dollars, Canada). Ces étranges objets virtuels sont utilisés pour créer des pièces de collection numériques uniques pour les amateurs de jeux sportifs, d’art et autres. Sorare propose « un jeu mondial de football fantastique où les joueurs peuvent acheter, échanger et jouer avec des cartes numériques officielles ». Ici, les seules sciences en jeu sont l’ingénierie sociale et la conception de l’expérience utilisateur ! Il est beaucoup plus facile de manipuler les émotions humaines que de se débarrasser de la décohérence quantique et des contraintes de mise à l’échelle des qubits.

Plus récemment, la blockchain et des crypto-monnaies ont été intégrées dans le concept « web3 » qui envisage un web décentralisé pour lutter contre la domination de Facebook, Google et Amazone de ce monde27. Là encore, ce n’est pas la science qui est en jeu, mais plutôt l’économie vaudou et une certaine architecture informatique qui peuvent aisément être déconstruites.

Enfin, il y a une différence significative par rapport à l’engouement pour le quantique : aucun pays développé ne finance (de manière significative) la recherche publique dans les domaines de la blockchain, des crypto-monnaies, des NFT et du web. C’est logique, étant donné que ces technologies sont conçues pour déconstruire le contrôle des gouvernements sur les monnaies. Seuls quelques pays comme le Salvador ou la Barbade ont adopté le bitcoin comme monnaie officielle28. D’autres pays tentent de le réglementer.

Le cas des innovations scientifiques

La célèbre courbe de hype de Gartner peut progresser ou s’arrêter après le « creux de la désillusion ». Lorsqu’elle s’arrête, comme le montre la courbe (1), cela peut être dû à des raisons sociétales et économiques (par exemple : il n’y a pas de véritable analyse de rentabilité, les gens n’aiment pas, ce n’est pas une priorité, c’est trop cher) ou à des obstacles scientifiques (ça ne marche pas encore, ce n’est pas sûr, etc.). Dans le domaine scientifique, quelles sont les promesses trop ambitieuses qui conduisent à une sorte de temps faible d’une technologie ?

Il y a d’abord les promesses qui relèvent de la fusion nucléaire. Il s’agit d’une promesse à long terme, bien qu’elle revienne à la mode avec quelques start-ups lancées dans ce domaine29. Celles-ci ont levé plus de 2 milliards de dollars à ce jour30. Pouvoir prédire quand, où et comment la fusion nucléaire pourrait être contrôlée pour produire de l’électricité est un défi aussi grand que de prévoir quand un ordinateur quantique évolutif pourrait être capable de casser des clés de chiffrement RSA de 2048 bits.

L’informatique non-conventionnelle a connu son lot d’échecs avec l’informatique optique et l’informatique supraconductrice. Nous entendons parler depuis un certain temps de la spintronique et des memristors qui sont encore en cours de développement. Ces technologies sont principalement étudiées par de grandes entreprises telles que HPE, IBM, Thales et d’autres. La médecine de précision fondée sur l’étude de l’ADN et l’ingénierie du génome a également été surestimée depuis environ 10 ans. Une certaine confusion a été faite entre les progrès du séquençage de l’ADN et ses applications dérivées dans les thérapies fondées sur la génomique. Il s’agit toujours d’un domaine prometteur. Le stockage de données à long terme basé sur l’ADN fait l’objet d’un nouvel engouement.

Ces cas sont très proches de la bulle quantique à plusieurs égards : leur dimension scientifique, la difficulté de vérifier les faits, les faibles niveaux de préparation technologique et l’incertitude scientifique. Ils suscitent également une prise de conscience plus faible dans le grand public que dans le cas des bulles non-scientifiques, comme avec les cryptomonnaies, les NFT et les métavers.

Conclusion

Nous avons vu que la bulle quantique présente des aspects différents par rapport aux bulles technologiques passées et actuelles, les principaux étant sa diversité technologique et la complexité de l’évaluation de ses avancées scientifiques et de ses feuilles de route. L’informatique quantique utile sera probablement une quête de longue haleine, qui s’étendra sur plusieurs décennies. La patience sera une vertu pour toutes les parties prenantes, en particulier les gouvernements et les investisseurs.

Parmi les technologies quantiques, l’informatique quantique a un niveau de maturité technologique (TRL) plutôt bas, avec une grande incertitude sur le résultat des ordinateurs quantiques à grande échelle à même de surpasser les grands supercalculateurs classiques. La recherche dans ce domaine est répartie entre des institutions universitaires et des entreprises de petite ou grande taille.

Par conséquent, il convient d’adopter une approche ouverte, fondée sur les faits et la science, pour évaluer les progrès et les feuilles de route. Cela nécessitera une plus grande visibilité et un plus grand engagement dans les médias, des scientifiques spécialistes du quantique, mais aussi un comportement plus transparent de la part des scientifiques devenus entrepreneurs.

Une collaboration et une coordination accrues pour faire de l’informatique évolutive une réalité, pourraient également être bénéfiques pour toutes les parties et tous les pays, un peu comme ce qui se fait actuellement autour de la fusion nucléaire.

Pour atténuer le battage médiatique, il faut également déployer des efforts considérables au niveau de l’éducation du public et auprès des professionnels. Enfin, l’innovation responsable et l’éthique des technologies quantiques devraient être étudiées et mises en œuvre le plus tôt possible afin de garantir la confiance de la société et des décideurs politiques dans les technologies quantiques.