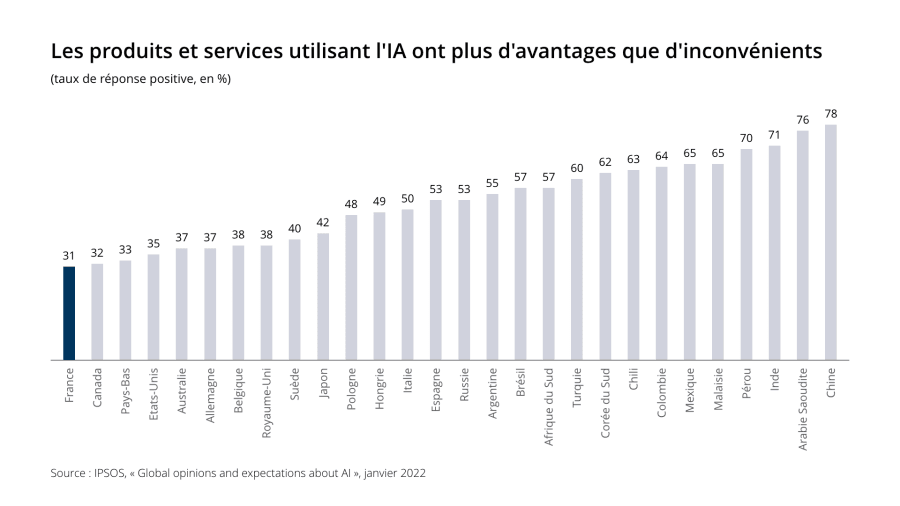

Pour une majorité de Français, l’intelligence artificielle (IA) constitue davantage une menace qu’une opportunité. À l’échelle internationale, la France se singularise par un pessimisme particulièrement marqué : la confiance dans les bénéfices de cette technologie y est deux fois plus faible qu’en Turquie, au Chili ou au Mexique.

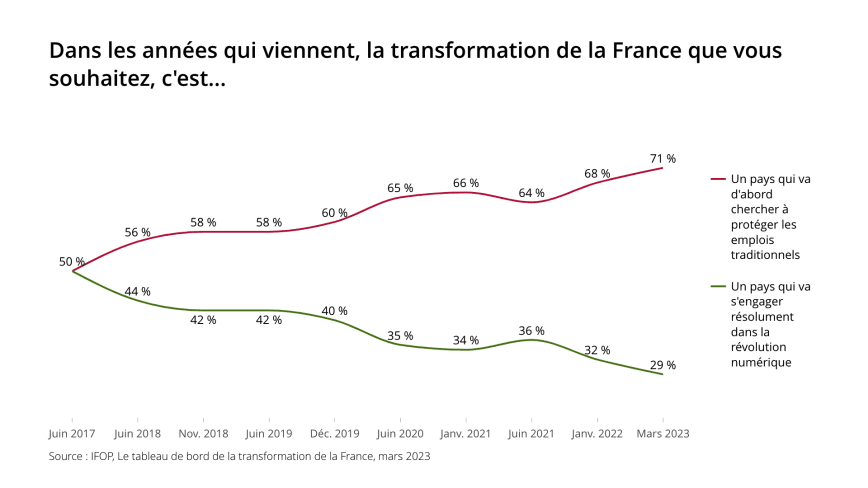

Alors que jamais un président de la République n’avait porté aussi clairement un discours d’ouverture sur l’innovation et le numérique, le raidissement des Français depuis 2017 est saisissant, en particulier sur la question de l’emploi.

Dans ce contexte, on peut craindre que le lancement du robot conversationnel ChatGPT, déjà testé par près d’un Français sur cinq, ne provoque une nouvelle vague d’inquiétudes. Pour la première fois, le grand public peut accéder, par le biais d’une interface facile d’utilisation, à une IA « générative » entraînée à partir d’un modèle de grande taille pour créer des contenus et effectuer des tâches que l’on pensait réservées aux humains.

De Marion Maréchal Le Pen à Jordan Bardella en passant par Eric Zemmour, l’extrême droite s’efforce déjà de capitaliser politiquement sur les angoisses suscitées par l’IA, en particulier sur les réseaux sociaux. Face au spectre du « grand remplacement » des humains par les robots, on est frappé par l’absence de discours cohérent du camp progressiste sur ce sujet.

Passer à côté de cette révolution serait pourtant lourd de conséquences.

Un gisement de croissance ?

Avant même le lancement de ChatGPT, l’apprentissage-machine (machine learning) était considéré par de nombreux économistes comme un candidat très sérieux pour s’imposer comme une « technologie d’usage général » (general-purpose technology) susceptible de transformer l’économie en profondeur, sans qu’il soit possible à ce jour d’en anticiper tous les usages.

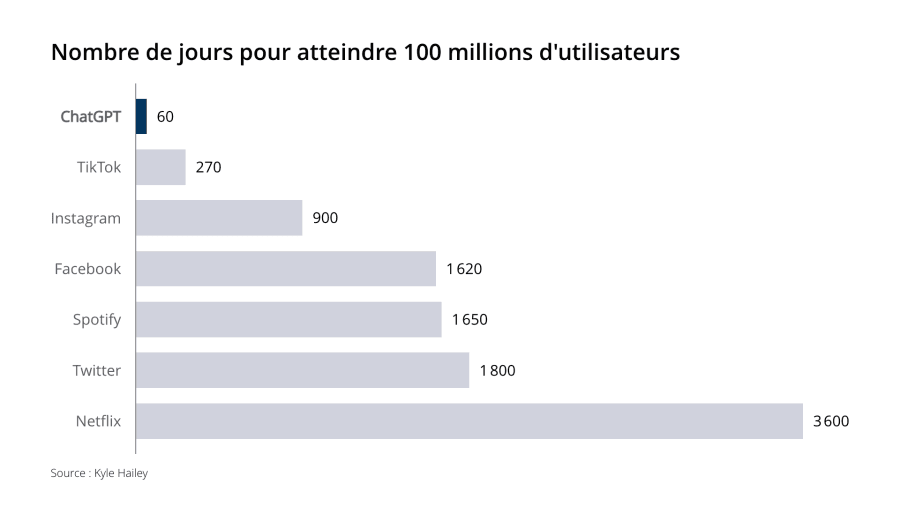

De ce point de vue, la rapidité avec laquelle ChatGPT a franchi le seuil de 100 millions d’utilisateurs est particulièrement impressionnante : 4,5 fois plus vite que TikTok, 27 fois que Facebook, 60 fois que Netflix ! De l’étudiant cherchant à rédiger une lettre de motivation à l’informaticien essayant de développer un nouveau programme, les publics se multiplient.

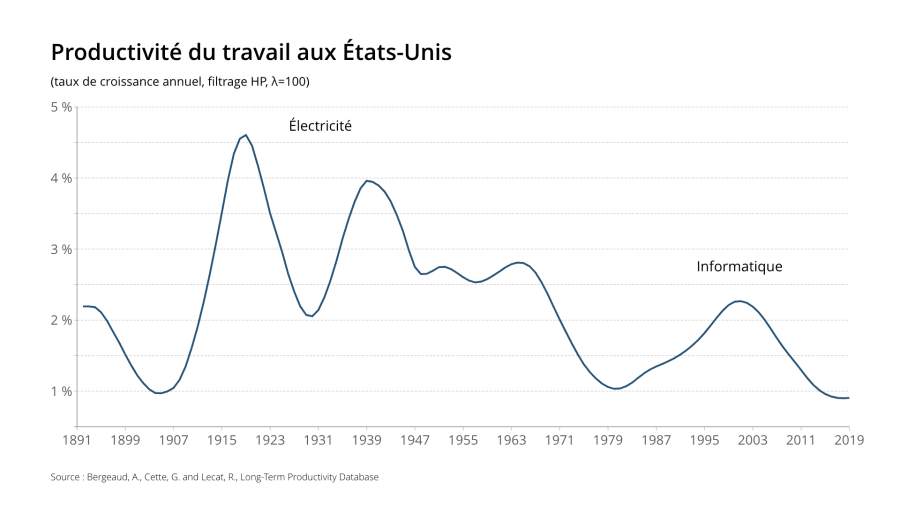

Après la machine à vapeur, l’électricité et l’informatique, l’IA pourrait bien être en mesure de générer une nouvelle vague de productivité, mettant fin à l’atonie de la croissance.

Peut-on donner un ordre de grandeur des enjeux ? Une étude récente de la banque américaine Goldman Sachs estime que le gain lié au développement de l’IA « générative » pourrait s’élever à plus de 7 points de PIB en zone euro en dix ans. Une telle hausse équivaudrait à l’intégralité des gains de pouvoir d’achat des Français ces quinze dernières années. Il en résulterait mécaniquement une réduction du déficit public du fait des recettes générées par ce surcroît d’activité, pouvant aller jusqu’à 4 points de PIB1 – ce qui serait suffisant pour ramener la France à l’équilibre budgétaire !

S’il s’agit bien sûr d’une estimation grossière fondée sur un nombre limité d’études empiriques et un jugement subjectif sur la part de l’économie susceptible d’être transformée par l’IA, nous disposons désormais d’éléments empiriques plus probants dans certains secteurs d’activité.

Il y a quelques jours, une première étude a permis d’évaluer les conséquences du déploiement à grande échelle d’un robot conversationnel pour aider plusieurs milliers d’agents chargés du service clientèle au sein d’une entreprise américaine, en leur suggérant des pistes de réponse en direct sur le chat. Elle met en évidence une hausse de la productivité de 14 %, accompagnée d’une augmentation de la satisfaction des consommateurs.

D’autres études réalisées à plus petite échelle donnent des résultats tout aussi favorables. Les développeurs informatiques assistés par une IA remplissent ainsi leurs tâches 56 % plus vite que ceux qui n’y ont pas accès. Il en va de même pour des professionnels recrutés en ligne pour réaliser des missions d’écriture rémunérées, qui s’acquittent de leurs tâches avec un gain de temps de 37 % grâce à l’assistance de l’IA. Motif supplémentaire de réjouissance : ces études ont toutes été réalisées dans l’univers des services, qui représente aujourd’hui l’essentiel de la valeur ajoutée des économies avancées mais qui peine jusqu’à présent à dégager des gains de productivité importants.

Un levier de réduction des inégalités ?

Reste la question de l’impact sur l’emploi, qui concentre les peurs.

En la matière, l’inquiétude est double.

La première est celle du « grand remplacement » des humains par les robots.

Dans le jargon des économistes, elle désigne la crainte que l’effet de « substitution » du travail humain par les machines domine l’effet de « réintégration » lié à l’émergence de nouveaux métiers et à la nécessité de répondre à la hausse de la demande provoquée par la baisse des prix. Plus le progrès technologique est « complémentaire » au travail humain, moins le risque est important.

À rebours des inquiétudes les plus courantes, la très grande majorité des études empiriques conclut à un effet net positif sur l’emploi des précédentes vagues d’innovation, y compris en France.

La deuxième crainte, plus sérieuse, concerne l’impact sur les inégalités.

Le progrès technologique peut se révéler « biaisé » en faveur des travailleurs qualifiés. Si la demande de travail augmente alors pour les plus diplômés, c’est l’inverse qui se produit pour les travailleurs peu qualifiés, ce qui provoque alors pour ces derniers du chômage et un décrochage salarial.

De nombreux économistes y voient une cause majeure de l’accroissement des inégalités et de la polarisation du marché du travail observés au cours des dernières décennies, car les dernières vagues d’innovation ont surtout permis d’automatiser les tâches « routinières » assurées par des travailleurs peu ou moyennement qualifiés.

Que peut-on dire de l’IA générative au regard de cette cartographie des risques ? Les premières études sont très rassurantes – et même franchement enthousiasmantes !

D’une part, cette innovation technologique serait très « complémentaire » au travail humain, ce qui minimiserait l’effet de « substitution ». Si Goldman Sachs estime ainsi que 70 % des emplois américains bénéficieront de gains de productivité liés à l’IA, 7 % seulement risquent d’être « remplacés » par les robots.

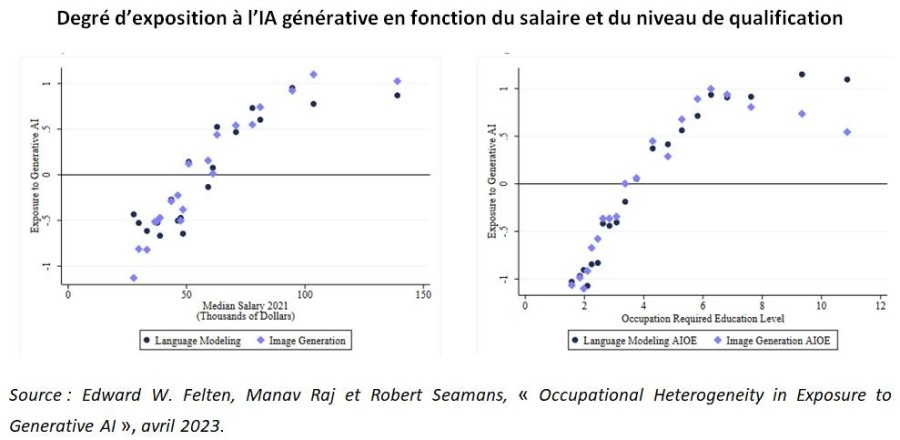

D’autre part, l’IA générative serait biaisée en faveur du travail peu qualifié, ce qui pourrait en faire un levier de réduction des inégalités.

En effet, les métiers où le risque de destruction d’emplois est le plus important semblent davantage occupés par les plus qualifiés et les mieux rémunérés. Contrairement aux précédentes vagues d’innovation, ce ne sont pas des tâches physiques ou répétitives qui sont touchées mais des tâches cognitives attachées aux emplois « intellectuels » et « créatifs ».

Degré d’exposition à l’IA générative en fonction du salaire et du niveau de qualification

Surtout, les premières études empiriques suggèrent que les gains de productivité bénéficient, au sein d’un même métier, essentiellement aux travailleurs les moins qualifiés.

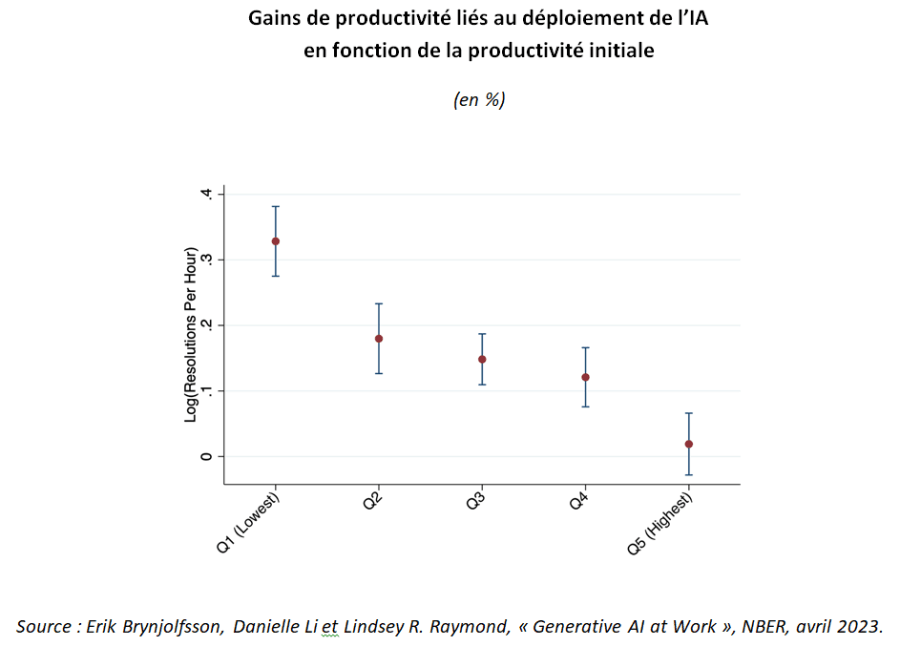

L’étude sur le déploiement de l’IA dans un service clientèle en est une bonne illustration : les gains de productivité sont pratiquement nuls pour les agents qui étaient les plus performants, alors qu’ils atteignent leur maximum pour les moins productifs (+ 33 %).

Gains de productivité liés au déploiement de l’IA en fonction de la productivité initiale (en %)

Le robot permet ainsi d’« augmenter » les capacités des travailleurs les moins performants, en mettant à leur service l’expérience accumulée par les plus productifs, qui a permis d’entraîner l’IA. Autrement dit, l’IA permet de socialiser et de mutualiser ce qui faisait l’avantage des plus productifs : elle « démocratise » leur avantage comparatif au sein de l’organisation concernée.

Si cette disparition de l’arbitrage entre productivité et inégalités se confirme, on mesure l’urgence d’un changement des représentations de l’innovation en France. Loin de creuser les inégalités, cette vague d’innovation permettrait de partager plus largement les bénéfices du savoir et de l’expérience au profit des plus fragiles, tout en remettant en causes les rentes des « cols blanc ».

Cette redistribution des cartes de la valeur sociale constitue une opportunité historique pour le camp progressiste, qui a toujours mis au centre de son projet la « maximisation des possibles » pour tous les individus. Une responsabilité aussi, car sa propre base électorale, où les cadres sont légion, risque cette fois de freiner des quatre fers.

En pratique, la recherche d’un nouveau consensus social sur le sujet supposera de relever trois défis.

Trois défis pour le camp progressiste

Le premier défi est celui de l’innovation et de sa diffusion.

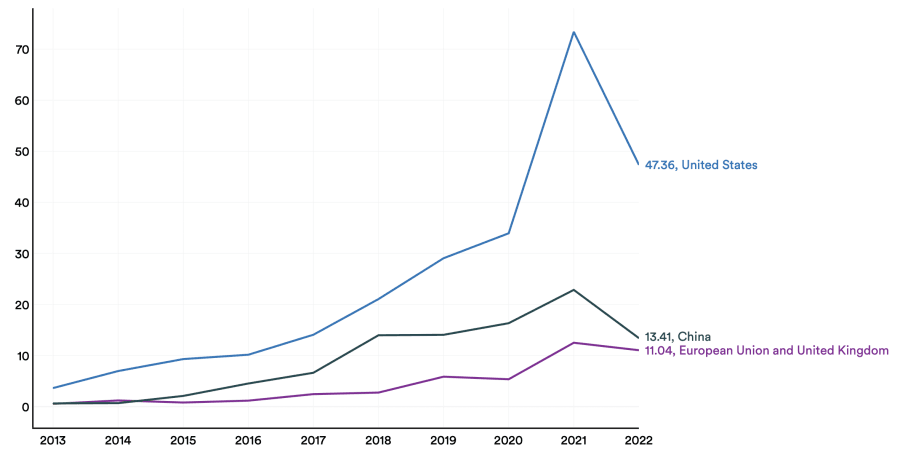

En la matière, l’Europe accumule un retard préoccupant sur le plan de l’investissement, en particulier dans le secteur privé : elle investit quatre fois moins que les États-Unis.

Investissement privé dans l’intelligence artificielle (en milliards de dollars)

Si la France tient son rang dans la recherche, elle souffre de ses travers traditionnels : déficit de collaboration entre acteurs, faible ouverture à l’international et manque d’intégration en aval. Ainsi que le résume l’OFCE, la France « court le risque d’être un laboratoire mondial de l’IA, situé en amont des activités d’innovation proprement dites, supportant les coûts fixes et irrécouvrables, sans trouver le relais nécessaire (…) quant à leur exploitation à plus grande échelle

».

Le deuxième défi est celui de la concurrence.

Comme le montrent Daron Acemoglu et Simon Johnson dans leur dernier ouvrage, la juste répartition des bénéfices de l’innovation ne dépend pas seulement des caractéristiques de la technologie mais également de l’organisation économique et sociale. Loin de bénéficier aux paysans, les gains de productivité majeurs liés à l’émergence de l’agriculture ont ainsi été captés par les grands propriétaires sous forme d’une hausse de leurs rentes. Plus proche de nous, les ouvriers anglais ont attendu près d’un siècle avant de bénéficier des gains de productivité liés à la révolution industrielle sous forme de hausses de salaires, du fait d’un rapport de force très favorable aux patrons.

Que faire pour limiter ce risque ? A court terme, la priorité est de prévenir l’émergence de très grandes entreprises capables de s’approprier durablement les gains de l’innovation en se constituant une rente monopolistique. Cela passe d’abord par une application stricte des règles de la concurrence tirant les leçons des précédentes vagues d’innovation dans le numérique, ainsi que par la promotion de solutions technologiques open source. Rappelons que la France joue un rôle clé pour bâtir une alternative ouverte à ChatGPT avec le projet Bloom, fondé sur une technologie comparable et entraîné sur le supercalculateur Jean-Zay, basé à Saclay.

Le dernier défi est celui de la régulation.

En la matière, l’erreur serait de « tout bloquer », à l’image de l’interdiction de ChatGPT décidée par l’Italie, ou de se concentrer sur des risques encore largement imaginaires, tels que l’émergence d’une « super-intelligence » capable de concurrencer l’humain, mise en avant par Elon Musk et ses co-auteurs dans une récente tribune appelant à un « moratoire » de six mois.

A l’inverse, les risques bien réels suscités par l’émergence d’agents conversationnels tels que ChatGPT ont été analysés de longue date par les spécialistes et doivent être pris en compte sans tarder. Paradoxalement, ils tiennent surtout… à leur manque d’intelligence. A la manière d’un « perroquet stochastique », ChatGPT assemble des séquences de mots qu’il a observées dans de vastes jeux de données d’apprentissage, en fonction d’analyses probabilistes sur la façon dont elles se combinent, mais sans aucune référence à leur signification. De ce fait, il peut « halluciner » et propager des fake news très convaincantes, ou répéter sans sourciller des stéréotypes et préjugés hérités des données qui ont servi à son entraînement.

En matière de régulation, l’Union européenne constitue naturellement le bon niveau d’intervention. Un premier cadre juridique transversal est d’ores et déjà en cours de finalisation, fondé sur une approche par le risque et pouvant aller, pour les cas d’usage les plus problématiques (ex : notation sociale), jusqu’à l’interdiction totale.

Pour assurer l’effectivité de ses règles et rassurer les citoyens, l’Union européenne devra assumer l’application extraterritoriale de son droit. Comme le rappelle Laurent Cohen-Tanugi, loin d’être une anomalie à combattre, l’extraterritorialité du droit constitue « la réponse naturelle au décalage entre la globalisation du monde et la fragmentation territoriale du pouvoir politique » et sert ensuite de fer de lance à l’harmonisation progressive des règles internationales.